Themes

Un focus su mondo dell'IA

Back to all

L'intelligenza artificiale è una bolla? Mentre ci avviciniamo alla seconda metà del 2024, questa è diventata la domanda da un trilione di dollari sulla bocca di tutti. A che punto siamo in questo ciclo tecnologico guidato dall'IA? In questo articolo discuteremo di come l'IA rimodellerà radicalmente il nostro lavoro e la nostra vita e stabiliremo se l'IA generativa ha le possibilità per trasformarsi in una rivoluzione tecnologica pluridecennale.

In primo luogo, riepilogheremo brevemente le principali tappe dello sviluppo dell'intelligenza artificiale dal lancio di ChatGPT nel novembre 2022. In secondo luogo, prevederemo alcune tendenze future del settore. Infine, andremo a discutere le nostre migliori scelte di IA per i mercati asiatici.

Scalabilità e legge di Huang: le capacità del modello aumentano mentre il costo dell'hardware diminuisce

Per cominciare, abbiamo fatto rapidi progressi nella ricerca dell'AGI (Artificial General Intelligence). Nel 2019, il nostro modello migliore era GPT-2, che riusciva a malapena a produrre qualche frase coerente. Nel 2024, il GPT-4, il nostro miglior modello, è in grado di produrre lunghi frammenti di codice e di ragionare su complessi problemi matematici. La magia che sta alla base di questo balzo stellare nelle prestazioni dei modelli è la legge di scalabilità, secondo la quale utilizzando ordini di grandezza maggiori di dati e risorse di calcolo per addestrare i nostri modelli, possiamo aspettarci miglioramenti significativi nelle loro capacità. Ciò ha spinto giganti tecnologici ricchi di denaro come Microsoft, Google e Meta a costruire cluster di addestramento di dimensioni mai viste prima, mentre gareggiano l'uno contro l'altro per avvicinarsi al sacro Graal della costruzione dell'AGI. Al centro di questi data center ci sono le GPU di Nvidia, che offrono le migliori prestazioni ed efficienza energetica della categoria.

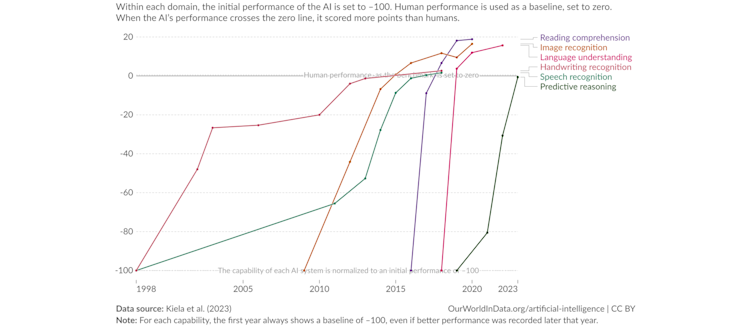

Punteggi di prova dei sistemi di IA su varie capacità rispetto alle prestazioni umane

Fonte: Our World in Data, 2024

L'implementazione dei sistemi di intelligenza artificiale prevede due fasi principali. In primo luogo, è necessario l'addestramento per ottenere un modello che possa essere utilizzato per diversi scopi. Poi, ogni volta che si accede al modello addestrato, si esegue un'inferenza. Per esempio, ogni volta che poniamo una domanda a ChatGPT, questo esegue un'attività di inferenza.

Per quanto riguarda l'addestramento, i costi totali di formazione per i modelli di ultima generazione continuano ad aumentare. La legge di scala richiede che i modelli aumentino rapidamente in termini di numero di parametri e di dati di addestramento, richiedendo molte più risorse di calcolo (GPU, rete, ecc.) per addestrare il modello di nuova generazione. Ad esempio, per addestrare GPT-4, l'attuale modello allo stato dell'arte, abbiamo bisogno di 8000 GPU Hopper di Nvidia. Tuttavia, per addestrare GPT-5 sono necessarie circa 100.000 GPU Hopper, il che rappresenta un aumento di 10 volte del costo dell'hardware. Sebbene l'infrastruttura attuale sia per lo più limitata all'adozione delle soluzioni di Nvidia, in futuro, con la concorrenza di altri fornitori di GPU o di Application Specific Integrated Circuit, ci sarà più spazio per migliorare i costi dell'hardware.

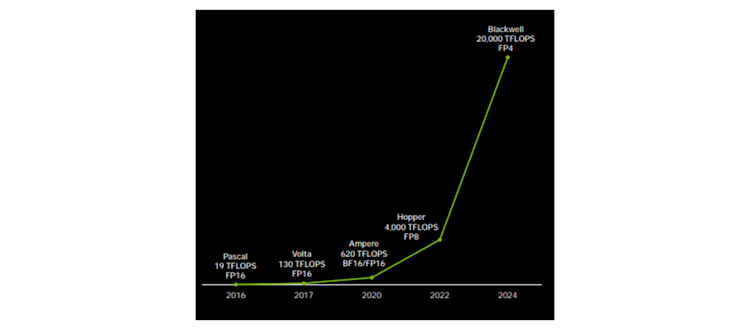

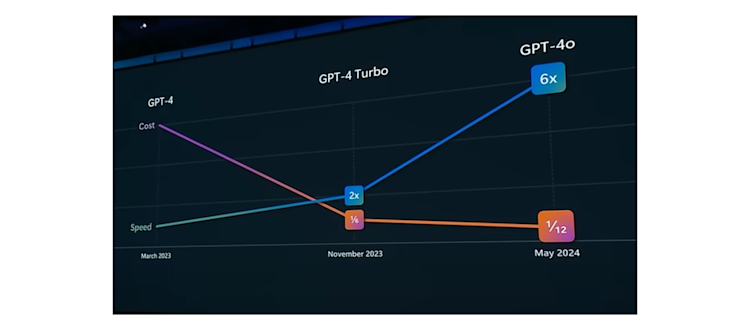

Per quanto riguarda l'inferenza, il costo si sta riducendo rapidamente. Il costo dell'inferenza per GPT-4 oggi è solo un dodicesimo di quello di un anno fa, grazie sia alle maggiori prestazioni hardware che alle migliori ottimizzazioni software. La legge di Huang, che prende il nome da Jensen Huang, stabilisce che la potenza di calcolo di ogni chip GPU raddoppia ogni anno, con un incremento di 1000 volte in un decennio. Le tecniche software come la quantizzazione, ovvero la rappresentazione dei parametri del modello con cifre a bassa precisione, sono diventate fondamentali e possono sfruttare i vantaggi dell'hardware per ridurre i costi di inferenza. Pertanto, mentre il costo dell'addestramento del modello più recente è in costante aumento, il costo dell'inferenza diminuirà gradualmente, aprendo la strada a una più ampia adozione dell'LLM.

Calcolo AI 1000x in 8 anni

Fonte: Nvidia GTC, 2024

Miglioramenti in termini di velocità e costi da GPT-4 a GPT-4o

Fonte: Microsoft Build, 2024

Siamo meno preoccupati per la disponibilità dei dati

Man mano che i modelli crescono rapidamente in dimensione, sempre più persone iniziano a chiedersi se abbiamo dati sufficienti per addestrare i modelli futuri. Attualmente abbiamo utilizzato tutti i dati testuali pubblici per l'addestramento, e sono stati la fonte di dati più importante. Tuttavia, ci sono ancora molti metodi per estrarre ulteriori dati a supporto delle esigenze della scalabilità. Le aziende conservano i dati proprietari all'interno dei loro data lake; quindi, le società di modelli come OpenAI stanno negoziando attivamente con aziende private per utilizzare i loro dati. Inoltre, possiamo utilizzare i modelli precedenti (ad esempio GPT-3.5) per generare dati da utilizzare per addestrare modelli futuri, noti come dati sintetici. Questo è analogo al modo in cui AlphaZero, il modello di intelligenza artificiale che ha raggiunto un livello sovrumano nel Go, è diventato progressivamente migliore giocando contro se stesso. Per imitare gli esseri umani, che possono apprendere concetti complessi con solo pochi esempi, vengono impiegate anche tecniche neuromorfiche come l'experience replay, che consente al modello di sviluppare più intuizioni utilizzando lo stesso insieme di dati. Sebbene la sufficienza dei dati continui a essere un argomento controverso, siamo meno preoccupati per questo problema almeno per i prossimi 2-3 anni.

Le abbondanti applicazioni di IA generativa rimodellano il nostro lavoro e la nostra vita

Attualmente l'IA generativa sta già trasformando le nostre abitudini di lavoro e di vita. I giganti di Internet utilizzano i DLRM (Deep Learning Recommendation Models) per suggerire contenuti più pertinenti agli utenti, come annunci pubblicitari o post sui social. Le aziende utilizzano modelli di linguaggio di grandi dimensioni (LLM) per assistere in compiti noiosi come la traduzione o la sintesi di testi. I programmatori utilizzano copiloti di codifica per accelerare lo sviluppo di applicazioni, individuare bug e suggerire miglioramenti. In futuro, il miglioramento delle prestazioni dell'IA insieme a costi di inferenza inferiori, aprirà senza dubbio nuovi mercati che non abbiamo ancora concepito, come l'avvento di piattaforme di e-commerce con la diffusione di Internet. L'IA generativa sarà anche uno dei principali motori della crescita economica. Secondo le stime di Goldman Sachs, nel prossimo decennio la tecnologia contribuirà ad un aumento di 0,4 punti percentuali nella crescita del PIL negli Stati Uniti, dello 0,2-0,4 punti percentuali in altri mercati sviluppati e dello 0,1-0,2 punti percentuali nei mercati emergenti avanzati.

L'IA sviluppa la comprensione e la generazione multimodale

Come continuerà a evolvere l'IA? Il primo passo sarà fornire più dati sensoriali all'IA. Non stiamo addestrando i modelli solo sui testi, ma anche su varie altre forme di dati, come immagini, audio e video, per rendere il modello più intelligente. Andrew Parker, un noto zoologo, ha proposto che, durante l'esplosione cambriana, la comparsa della vista sia stata fondamentale per i primi animali non solo per trovare il cibo ed evitare i predatori, ma anche per evolversi e migliorare. Allo stesso modo, permettere all'intelligenza artificiale di vedere i dati oltre il semplice testo dovrebbe portare a ulteriori scoperte. Nella sua teoria del 1952, lo psicologo svizzero Jean Piaget suggerisce che i bambini sviluppano le capacità cognitive attraverso esperienze sensoriali come vista, udito, tatto, gusto e olfatto e attraverso le interazioni con il mondo fisico. Sebbene oggi i sistemi di IA siano ancora limitati nelle capacità percettive sensoriali, lo sviluppo di robot umanoidi alimentati da LLM fornirà probabilmente interazioni maggiori e arricchite tra i modelli e il mondo fisico, rendendoci ottimisti del potenziale di intelligenza a lungo termine dell'IA.

L'intelligenza artificiale sviluppa le capacità di ragionamento passo-passo di System-2

Abbiamo anche esplorato il modo in cui i modelli possano pensare in modo più simile agli esseri umani. Ad esempio, i ricercatori stanno incorporando metodi come il “chain of thought prompting” per consentire ai modelli di ragionare passo dopo passo quando risolvono un problema complesso. Questo metodo è analogo al pensiero del Sistema 2, che si riferisce a un processo cognitivo lento e deliberato, in contrasto con il pensiero del Sistema 1, che è veloce, automatico e intuitivo (più simile a come funzionano oggi i LLM). I ricercatori hanno scoperto che utilizzando il “chain of thought prompting”, le prestazioni del modello migliorano nel ragionamento aritmetico, nel ragionamento simbolico e nel ragionamento di senso compiuto.

L’IA come veicolo promettente per perseguire l'AGI

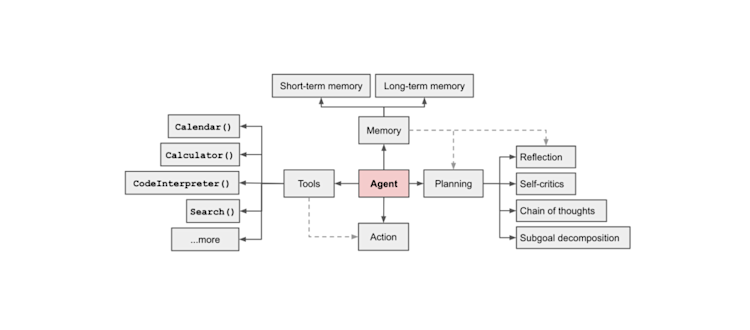

La riduzione dei costi di calcolo, i progressi nella comprensione e nella generazione multimodale, le architetture di modelli più efficienti e le maggiori capacità di ragionamento e pianificazione contribuiranno allo sviluppo di agenti di IA avanzati. Un agente di IA è considerato un veicolo promettente per perseguire un'intelligenza artificiale a livello umano. Lilian Weng di Open AI descrive un agente di IA alimentato da LLM come un sistema con un LLM come cervello, dotato di memoria a breve e a lungo termine, in grado di pianificare in più fasi e di utilizzare strumenti come le chiamate API. Alcune primi prototipi, come Devin, mostrano il potenziale di un agente AI progettato per risolvere individualmente compiti di codifica complessi. I ricercatori stanno anche sviluppando sistemi multi-agente, poiché hanno scoperto che un agente specializzato in un dominio ristretto di compiti supera gli agenti generalisti, in modo analogo alla “divisione del lavoro”, proposta per la prima volta da Adam Smith. In futuro, crediamo che vedremo una coesistenza armoniosa tra i sistemi multi-agente e gli esseri umani.

Panoramica di un sistema di agenti autonomi alimentato da LLM

Fonte: Lilian Weng, 2023

AI drives transformational change in robotics L'IA guida la trasformazione della robotica

L'IA è anche alla base di un cambiamento trasformativo nella robotica, che sbloccherà risorse illimitate e aumenti di produttività, creando un cambiamento epocale nell'economia globale. Grazie ai LLM, i ricercatori hanno conferito ai robot capacità di visione, pianificazione e interazione con gli esseri umani. Per esempio, un team di Google ha sviluppato un progetto in cui il robot può agire ragionando sugli stati attuali dell'ambiente e sulle sue abilità. Quando gli viene chiesto “Ho rovesciato la mia Coca-cola, puoi aiutarmi?”, il robot valuta quali strumenti disponibili nell'ambiente potrebbero essere utili e quali azioni può intraprendere. Può quindi raccogliere una spugna per aiutare, invece di fare qualcosa di irrilevante.

Un mondo eterogeneo in cui coesistono modelli grandi e modelli piccoli

Models I modelli devono essere commercializzati e trasformati in prodotti. Si stanno realizzando modelli linguistici specializzati e di piccole dimensioni, adatti a compiti o flussi di lavoro specifici. Ad esempio, Apple utilizza un modello on-device da circa 3 miliardi di parametri addestrato per attività specifiche come la sintesi, la correzione di bozze o la generazione di risposte alle mail. Le tecniche per trasformare i modelli di grandi dimensioni in modelli più piccoli, come la distillazione o la potatura, si sono notevolmente evolute. Immaginiamo un futuro eterogeneo in cui i ricercatori continuano a sviluppare modelli cloud più competenti con comportamenti emergenti, mentre modelli più piccoli basati su edge, con migliore sicurezza e minore latenza, vengono implementati sui nostri PC e dispositivi mobili.

Taiwan, Corea e Giappone sono al centro della supply chain

Come partecipare a questo viaggio nell'IA? Molti investitori potrebbero pensare di poter investire solo in aziende statunitensi per trarre vantaggio da questo fenomeno, ma ci sono molte aziende asiatiche che stanno contribuendo significativamente allo sviluppo dell'IA. Taiwan, Corea e Giappone sono al centro della catena di fornitura. Diamo un rapido sguardo a qualche esempio.

TSMC (2330-TW) detiene una posizione di monopolio di fatto nella produzione dei chip delle GPU Nvidia, il silicio personalizzato utilizzato dai cloud provider statunitensi, e dei chip di rete. Inoltre, supporta un tema più ampio di IA producendo chip per telefoni cellulari e PC, dove le applicazioni di IA si manifestano sempre di più.

SK Hynix (000660-KR) è il più grande fornitore di chip di memoria a larghezza di banda elevata (HBM). Questi chip di memoria specializzati gestiscono la larghezza di banda elevata richiesta per l'addestramento e l'inferenza dei modelli di IA attuali.

Disco (6146-JP) è leader mondiale nella produzione di smerigliatrici e cubettatrici utilizzate nella produzione di chip per semiconduttori. Le macchine Disco svolgono un ruolo fondamentale nella produzione di questi chip HBM altamente sofisticati, che richiedono la macinazione dei chip a un livello ultra-sottile. Solo le macchine che esercitano un'alta precisione e un'elevata planarità sono in grado di farlo. Con i suoi 50 anni di storia nell’attrezzatura per semiconduttori di precisione, Disco è una forza dominante nel permettere la produzione di chip HBM.

Conclusioni: Siamo ottimisti sull'IA generativa

Molti ricercatori ritengono che le reti neurali digitali siano concettualmente simili ai cervelli biologici. I parametri dei modelli sono analoghi alle sinapsi del cervello, ovvero alle connessioni tra i neuroni. Un cervello umano ha 100.000 miliardi di sinapsi. Maggiore è il numero di sinapsi, maggiore è l'intelligenza che ne deriva. Oggi si ritiene che il GPT-4 abbia 1,8 trilioni di parametri e la scalabilità fino a 100 trilioni è la direzione in cui vogliamo testare il limite della legge di scala.

In conclusione, nonostante lo scetticismo sulla sostenibilità della legge di scala e sui tempi di commercializzazione dell'IA generativa, siamo ancora ottimisti sulla tendenza generale. I costi dell'hardware continueranno a diminuire grazie alla legge di Huang, consentendo una più ampia adozione dell'IA generativa. Inoltre, i progressi del software, come l'addestramento con più modalità di dati o la possibilità di auto-apprendimento del modello, sbloccheranno ulteriori capacità. Il progresso dell'IA fisica potrebbe essere l'ultimo tassello mancante per la realizzazione dell'AGI, man mano che i robot iniziano a integrarsi perfettamente nella nostra società per risolvere compiti più complicati.

INFORMAZIONI IMPORTANTI

Degroof Petercam Asset Management SA/NV (DPAM) l rue Guimard 18, 1040 Bruxelles, Belgio l RPM/RPR Bruxelles l TVA BE 0886 223 276 l

Questa è una comunicazione di marketing. Le prestazioni passate non sono indicative delle prestazioni future.

Tutti i diritti restano di DPAM, autore del presente documento. È vietata la memorizzazione, l'uso o la distribuzione non autorizzata. Sebbene il presente documento e il suo contenuto siano stati redatti con la dovuta cura e si basino su fonti e/o fornitori di dati terzi che DPAM ritiene affidabili, essi vengono forniti senza alcuna garanzia di alcun tipo e senza garanzie di correttezza, completezza, affidabilità, tempestività, disponibilità, commerciabilità o idoneità a uno scopo particolare. Tutte le opinioni e le stime riflettono la situazione al momento dell'emissione e possono cambiare senza preavviso. Il cambiamento delle circostanze di mercato può invalidare le dichiarazioni contenute nel presente documento.

Le informazioni fornite nel presente documento devono essere considerate di carattere generale e non intendono in alcun caso essere adattate alla vostra situazione personale. Il suo contenuto non rappresenta una consulenza di investimento, né costituisce un'offerta, una sollecitazione, una raccomandazione o un invito ad acquistare, vendere, sottoscrivere o eseguire qualsiasi altra operazione con strumenti finanziari. Il presente documento non è destinato agli investitori di una giurisdizione in cui tale offerta, sollecitazione, raccomandazione o invito sarebbe illegale. Il presente documento non costituisce nemmeno una ricerca indipendente o obiettiva in materia di investimenti o un'analisi finanziaria o un'altra forma di raccomandazione generale su operazioni in strumenti finanziari, come indicato all'articolo 2, 2°, 5 della legge del 25 ottobre 2016 relativa all'accesso alla prestazione di servizi di investimento e allo status e alla vigilanza delle società di gestione del portafoglio e dei consulenti per gli investimenti.